Met z’n tweeën namen we de proef op de som en haalden GPT-4 door de mangel van een gratis online IQ-testje. De AI haalde minimaal MBO+ tot HBO-niveau.

ChatGPT is het gesprek van de dag, zeker onder computerliefhebbers. Het duurde dan ook niet lang of het gesprek kwam op de verbeterde engine achter de laatste incarnatie van deze chatbot, GPT-4. Is GPT-4 inderdaad zo intelligent als een mens?

IQ van GPT-4 getest

Het was dus onvermijdelijk dat we op ons wekelijkse nerdy avondje, tussen het bekijken van de Netflix sciencefictionserie The Expanse door, de proef op de som probeerden te nemen. Sommige psychologen definiëren intelligentie als datgene wat IQ-testen meten. En getallen zijn cool.

Mini-testje

Zou het mogelijk zijn om een IQ-test af te nemen bij GPT-4? We besloten om het te proberen. Als slachtoffer kozen hiervoor een kleine gratis IQ-test, de Gratis IQ test | 123test.nl.

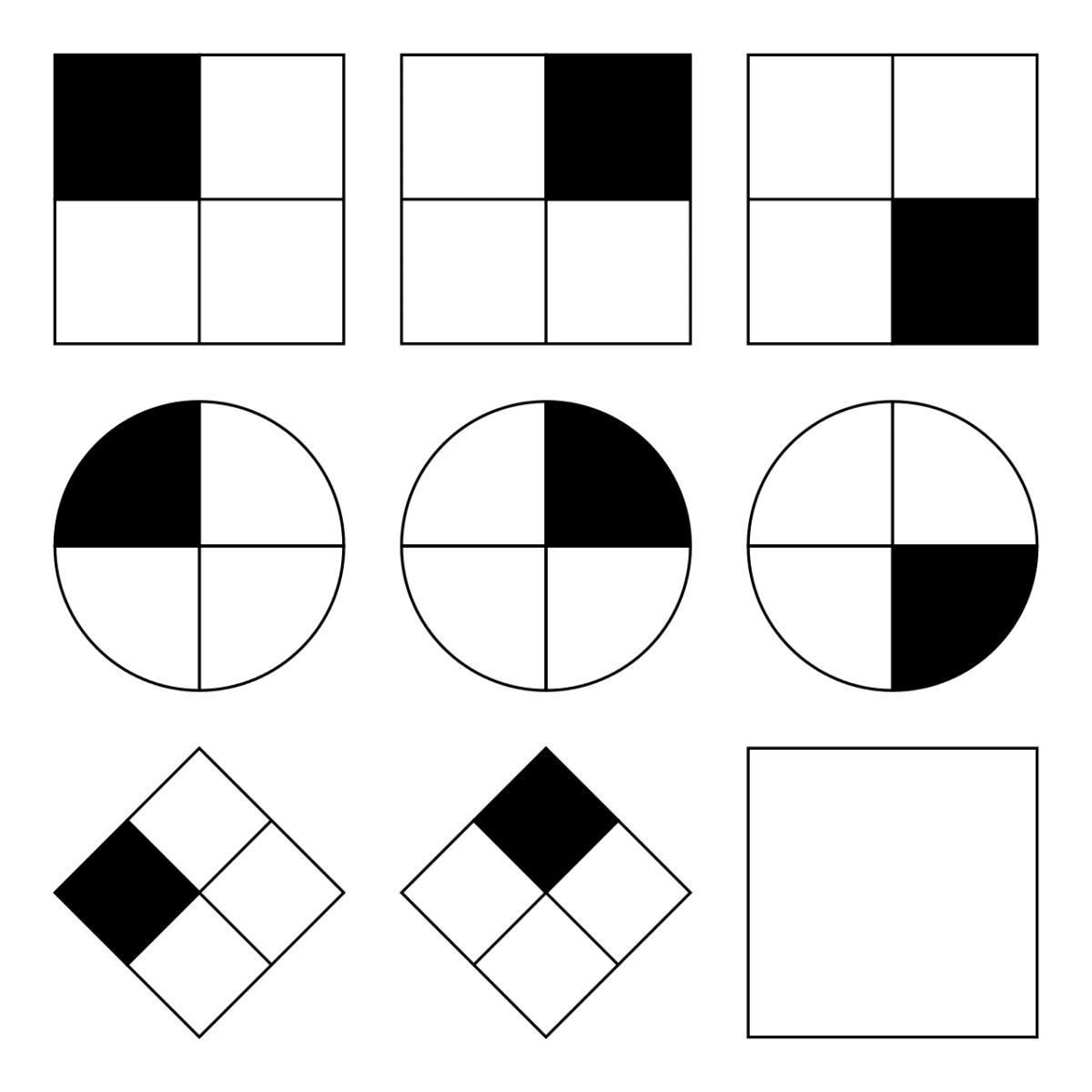

Het probleem met dit testje met tien vragen was dat het zowel verbale als non-verbale vragen bevat. De versie van GPT-4 waar je via Bing of de webinterface van OpenAI toegang tot hebt, is niet in staat om plaatjes te ontvangen. Daardoor was het bij meerdere IQ-vragen niet mogelijk om ze aan de chatbot te stellen. Zo konden we een van de lastiger IQ-vragen, voorspellen welke van de zes opties mogelijk was bij een gegeven uitslag van een kubus, niet stellen. Waarschijnlijk heeft dit de score gedrukt. In enkele gevallen konden wij een grafische vraag omzetten in een patroon met tekens, en dit patroon als vraag stellen aan GPT-4.

GPT-4 vooral goed in verbale analogieën

In ons informele onderzoekje bleek GPT-4 geen enkele moeite te hebben met verbale analogieën en redactiesommen, en gaf hier in alle gevallen het juiste antwoord. Bij cijferreeksen gaf de chatbot in eerste instantie een fout antwoord. Toen we een ondersteunde keuze aanboden met vier opties, zoals een menselijke testnemer ook te zien krijgt, gaf de chatbot alsnog het juiste antwoord. Bij een figurenreeks vervingen we de aantallen tekens door cijfers, bijvoorbeeld twee blokjes boven drie cirkeltjes boven nul driehoekjes door (2,3,0).

GPT-4 bleek drie van de tien vragen fout te hebben, inclusief de twee niet-afgenomen non-verbale vragen (kubusuitslag en samengestelde figuur). Daarmee behaalde de chatbot een IQ tussen de 108 en 120. Heel behoorlijk, zeker als je bedenkt dat door technische beperkingen twee vragen niet afgenomen konden worden. Uiteraard is dit testje te klein voor een echt representatief onderzoek, psychometrisch gezien wil je minimaal 19 vragen om een meetwaarde grondig te testen.

Afnemen Raven matrixtest helaas niet mogelijk, wegens technische beperking

Volgens veel intelligentieonderzoekers meten non-verbale IQ-testen, zoals de Raven matrixtest, het “fluïde” IQ, het niet-aangeleerde IQ, beter. Helaas, weer om de bekende technische reden, kunnen we deze niet rechtstreeks afnemen. Maar een voorzichtige conclusie lijkt te zijn dat GPT-4 behoorlijk slim is en tekenen begint te tonen van kunstmatige algemene intelligentie (AGI). Deze conclusie wordt gedeeld door een team Microsoft-onderzoekers.